黃仁勳CES發表自駕AI、超級晶片 演講3大亮點一次看

(中央社記者吳家豪台北6日電)輝達(NVIDIA)執行長黃仁勳今天在美國消費性電子展(CES)發表主題演講,公布自駕車AI技術Alpamayo、AI超級電腦Vera Rubin、次世代基礎設施與網路3大亮點,並提到「實體AI的ChatGPT時刻已經到來」、「機器人將在電腦中誕生」等多個引人注目的金句。

黃仁勳強調,這是一次10年一遇的「平台轉移」,人工智慧(AI)是由能源、晶片、基礎設施、模型與應用程式組成的5層架構,輝達致力於全堆疊(Full Stack)技術的開發。

黃仁勳說,未來人類不再是「編寫」軟體,而是透過資料「訓練」軟體;運算中心也不再由中央處理器(CPU)主導,而是轉向繪圖處理器(GPU)。

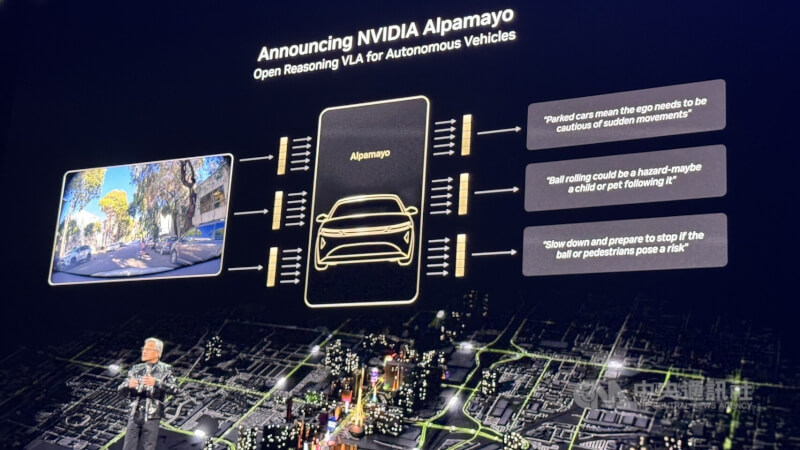

一、發表Alpamayo:全球首款會思考的自駕AI

黃仁勳在演講中發表自動駕駛推理模型Alpamayo,為全球首款具備思考與推理能力的自駕AI,在攝影機輸入大量資料,包括自動駕駛的里程,以及由人類駕駛示範的數據,並加入大量由Cosmos世界模型生成的場景,對數十萬個範例進行精細的標註,藉此教導汽車如何駕駛。

「實體AI的ChatGPT時刻已經到來」,黃仁勳說,Alpamayo的特別之處在於,它不僅能接收感測器輸入並操作方向盤、煞車與加速,還會針對即將採取的行動進行推理,說明它打算做什麼、為什麼採取這個行動,以及預計行駛軌跡。

黃仁勳指出,在駕駛過程中,即使是再罕見的極端狀況,只要分解成多個較小的場景並透過「推理」,汽車就能將這些極端狀況分解成它已知如何處理的正常情況。

首款採用輝達技術的自駕車將於今年第1季在美國上路,第2季進入歐洲,並於第3、4季進入亞洲。

輝達今天也推出專為人形機器人設計的開放模型GR00T N1.6、具備推理能力的視覺語言模型Cosmos Reason 2,以及搭載Blackwell架構的Jetson T4000模組,並與開源社群平台Hugging Face合作,將輝達Isaac機器人平台和GR00T基礎模型納入LeRobot開源框架,連結全球超過1300萬名開發者。

黃仁勳指出,「機器人將在電腦中誕生,在應對現實世界的重力之前,它們已經在虛擬世界中完成了設計、製造與測試。」

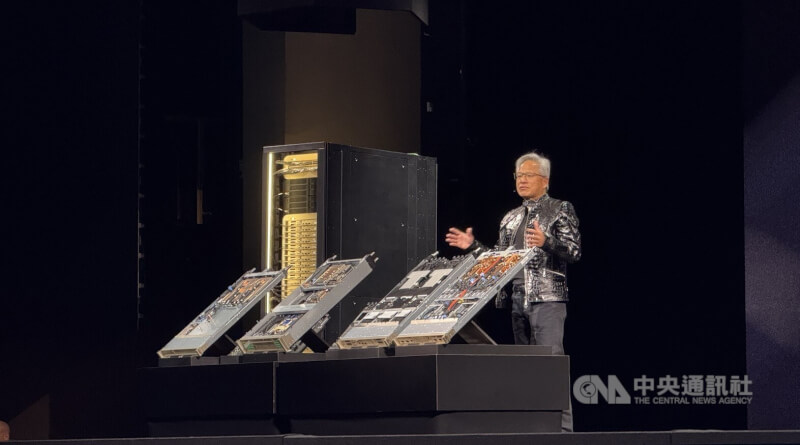

二、AI超級電腦Vera Rubin已全面量產

黃仁勳說,AI所需的運算量正以天文數字成長,輝達GPU的需求正直線攀升,因為AI模型的規模每年都以10倍速度增加。

他表示,AI的競賽非常激烈,每個人都在努力邁向下一代領先技術,每當技術達到新境界,上一代詞元(Token)生成的成本就會下降約10倍。「你運算的速度越快,就能越早達到下一個技術巔峰」,因此輝達決定每年都要推進運算技術的最前沿,不浪費任何一年,目前Vera Rubin已全面量產(full production)。

Vera Rubin平台由6款全新晶片組成,包括Vera CPU、Rubin GPU、NVLink 6交換器、ConnectX-9 SuperNIC智慧網卡、BlueField-4資料處理器、Spectrum-6以太網路交換器。與前一代 Blackwell平台相比,Vera Rubin推論成本僅需1/7,訓練混合專家模型(MoE)所需的GPU數量僅1/4。

「大家知道輝達製造晶片,但現在,輝達製造的是完整的系統」,黃仁勳表示,除非進行「極致協同設計」,同時對所有晶片與整個堆疊進行創新,否則產業將無法持續進步。

三、次世代基礎設施與網路

黃仁勳在演講中提到,輝達徹底改造了用於模組化伺服器設計的MGX機箱,過去這種機箱充滿複雜的纜線,組裝需要2小時且容易出錯。現在透過液冷核心設計,組裝時間從2小時縮短到5分鐘。

此外,儘管Rubin平台的效能大幅提升,卻能直接使用45度的溫水進行冷卻,這意味著資料中心不需要冷水主機,能節省全球資料中心約6%的電力。

黃仁勳說,輝達推出的Spectrum-X乙太網路交換器平台,能提供比標準乙太網路高出25%的吞吐量。對於一座耗資500億美元的資料中心而言,10%的性能提升就價值50億美元,省下的錢等於讓網路設備變成免費。

隨著AI對話變長,上下文記憶體急劇增加,輝達推出Bluefield-4,讓每個GPU額外獲得16TB的記憶體儲存空間,解決了詞元(Token)生成的傳輸瓶頸。

黃仁勳在演講尾聲表示,輝達正從晶片、基礎設施、模型與應用面向,全方位重新發明AI,讓所有人能為世界創造出令人驚嘆的應用。(編輯:楊凱翔)1150106

- 2026/02/18 15:33

- 2026/01/08 13:02

- 2026/01/07 11:36

- 黃仁勳CES發表自駕AI、超級晶片 演講3大亮點一次看2026/01/06 09:10

- 2026/01/04 20:45

- 2025/12/30 18:24

本網站之文字、圖片及影音,非經授權,不得轉載、公開播送或公開傳輸及利用。