別把AI當醫師 台大研究:3大生成式AI表現不及格

(中央社記者沈佩瑤台北6日電)不少人習慣凡事先問ChatGPT等生成式AI,台大公衛學者近期完成全球首項「生成式AI」在中風照護資訊提供上表現評估,發現臨床表現幾乎都低於60分,提醒民眾別把AI當醫師,恐危及生命。

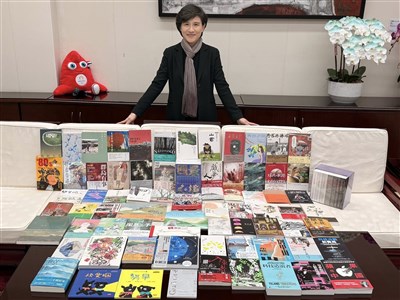

台大公衛學院副教授、玉山青年學者李達宇今天在成果發表會中分享,他小時候,醫師是尋求健康照護答案的主要資訊來源,後來進入網際網路時代,開始習慣上網搜尋,如今科技突飛猛進,生成式AI成了不少人的生活借問站。

李達宇指出,這篇研究主要在談慢性病,因為病人就算一年看30天病,換言之仍有高達335天時間必須自我照護,過去他照顧生病媽媽,便曾因媽媽出現皮膚問題,而尋求ChatGPT幫助。

由於許多病人使用ChatGPT等工具,詢問中風復原及相關症狀衛教資訊。李達宇說明,研究團隊以ChatGPT、Claude、Gemini3大主流語言模型,模擬多種貼近臨床情境的中風照護場景,運用多種提示設計策略,全面評估準確性、同理性、可操作性與安全性等面向的表現。

研究團隊發現,3大語言模型在個提示工程方法(ZSL、COT、TOT)下的臨床整體表現,皆低於合格門檻60分,少數情境可略高於60到65分。此外,這3種AI在「提供患者可直接採取行動的建議」方面表現不一,尤其在中風治療等高風險階段,錯誤或不完整回應時有所見。

這項研究在今年7月刊登於「npj 數位醫學」(Digital Medicine)期刊,李達宇的結論是,「生成式AI在一般健康資訊傳遞上也許具有潛力,但在中風這類即時且需專業介入的情境上,可靠性仍有待大幅提升。」

李達宇說,在高風險的醫療照護中,即使是微小的錯誤,也可能付出生命代價,因此在AI發展過程中,教導病人「如何安全使用AI」,與技術發展同等重要。

就算是日常的保健資訊,李達宇提醒,當使用語言模型時,不妨加入自己的性別、年齡、家族病史、環境暴露情況、用藥與就醫資訊,以提高健康資訊的可信度。

台大醫院環境及職業醫學部主治醫師陳保中呼籲,不能把AI當醫師,AI只能作為輔助工具,病人可以詢問AI自己該看哪一科,而不是靠AI做出醫療決定。(編輯:陳清芳)1141106

本網站之文字、圖片及影音,非經授權,不得轉載、公開播送或公開傳輸及利用。